(openPR) Doch nun hat eine internationale Forschungsgruppe um den Quantenphysiker Prof. Jens Eisert von der Freien Universität Berlin unerwartetes Ergebnis innerhalb der Quantentheorie aufgedeckt – und dabei einen fundamentalen Fortschritt im Verständnis der sogenannten Quantenverschränkung erzielt. Die Studie „Entanglement theory with limited computional resources“ ist gerade in der renommierten Fachzeitschrift Nature Physics, erschienen. Sie zeigt: Was bislang als Goldstandard zur Messung quantenmechanischer Korrelationen galt, funktioniert in der Praxis womöglich nicht so wie gedacht.

Die bereits in den 1920er Jahren entwickelte Quantentheorie ist eine grundlegende Theorie der Physik, die das Verhalten von Teilchen auf kleinster Ebene – wie Atomen und Lichtteilchen – beschreibt. Anders als in der klassischen Physik können diese Teilchen sich gleichzeitig in mehreren Zuständen befinden und über große Entfernungen miteinander „verschränkt“ sein. Die Verschränkungstheorie ist ein zentrales Element der Quantenmechanik und bildet die Grundlage für viele moderne Technologien wie Computerchips, Laser oder Quantencomputer über sicherer Kommunikation bis hin zu neuen Quantenmaterialien.

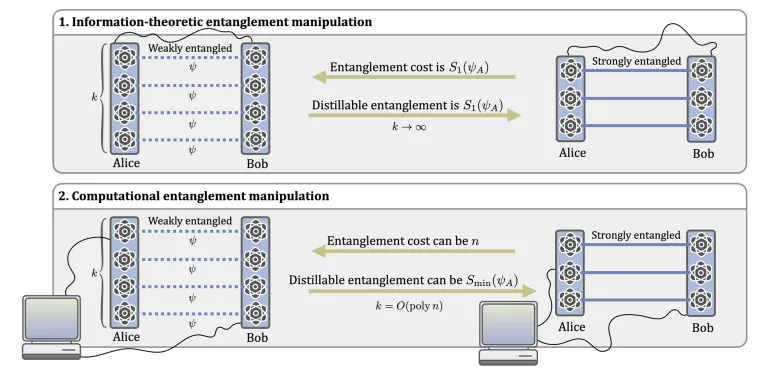

Bislang wurde angenommen, dass verschränkte quantenmechanische Zustände durch ganz allgemeine Operationen effizient kontrolliert werden können, die im Labor nach den Regeln der Quantentheorie durchgeführt werden können, ohne weitere Einschränkungen als Lokalität. Doch nun zeigen die Wissenschaftlerinnen und Wissenschaftler, dass die praktische Nutzung von Quantenverschränkung erheblich durch reale Rechenbeschränkungen limitiert ist – selbst bei ideal bekannten Zuständen. „Unser Verständnis der Verschränkung basierte bislang auf idealisierten Annahmen“, erklärt der Quantenphysiker Jens Eisert. „Wir zeigen jetzt in unsere Arbeit, dass sich zentrale Größen der Quanteninformationsverarbeitung unter realistischen, also effizient berechenbaren Bedingungen fundamental unterscheiden.“

Die Forschenden führen dafür zwei neue quantenphysikalische Größen ein: die computational distillable entanglement und die computational entanglement cost. Beide beschreiben, wie viele verschränkte Quantenzustände – sogenannte „Ebits“ – man mit begrenzten Mitteln wirklich extrahieren oder erzeugen kann.

Die Arbeit könnte das Verständnis von quanteninformativen Prozessen grundlegend verändern und eine neue, realistischere Ressourcentheorie für Quanteninformation begründen. Zudem zeigt sie eine neue Perspektive für Effizienzprobleme heutiger Quantencomputer auf – jenseits bloßer Hardwarefragen. So ergibt sich auch eine neue Verbindung zwischen der theoretischen Informatik - die sich damit beschäftigt, wie komplex und schwierig bestimmte Rechenoperationen sind - und der Physik, die versucht, die Natur zu verstehen.

Bemerkenswert ist Jens Eisert zufolge auch die Erkenntnis, wie ein gewisser Widerspruch in der Quantentheorie über Jahre übersehen wurde: „Offenbar haben sich zwei zentrale Forschungsfelder – die Verschränkungstheorie und die von Quantenalgorithmen – zu wenig ausgetauscht“, sagt der Physiker. Genau an dieser Schnittstelle setzte die aktuelle Arbeit an. Sie unterstreicht, dass spannende Forschungsthemen oft an Schnittstellen zwischen Forschungsfeldern entstehen – „also an ‚kulturellen Lücken‘ - oder metaphorisch gesprochen zwischen den Stühlen oder an den tektonischen Bruchlinien von etabliertem Wissen. Die Quantentheorie ist hier keine Ausnahme“, sagt Eisert.

wissenschaftliche Ansprechpartner:

Prof. Dr. Jens Eisert, Freie Universität Berlin, Dahlem Center for Complex Quantum Systems, E-Mail: ![]()

Originalpublikation:

https://www.nature.com/articles/s41567-025-03048-8