(openPR) Künstliche Intelligenz erzeugt heute in Sekunden vermeintlich echte Bilder, Stimmen und Videos.

"Deepfakes" sind längst nicht mehr Nischenphänomene, sondern ein skalierbares Geschäfts- und Manipulationsmodell.

Ein oft unterschätzter Treiber: unverlässliche Quellengenerierung aus dem Internet. Wo Modelle auf fragwürdige Inhalte trainiert werden oder Generationssysteme bei der Recherche auf irreführende Seiten zurückgreifen, entsteht ein Kreislauf aus Fehlern, der Authentizität in den Hintergrund manövriert - technisch, kommunikativ und gesellschaftlich.

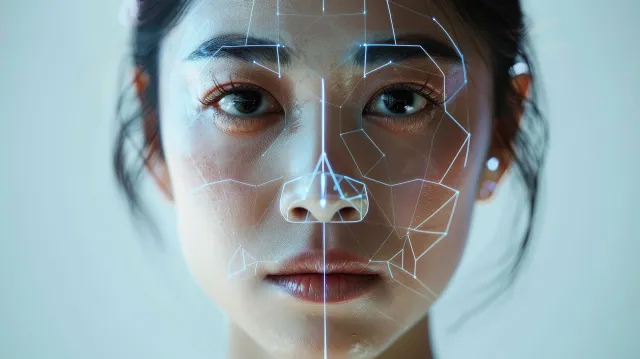

Wie entstehen eigentlich Deepfakes?

Datenbasis: Bild-, Audio- und Videodaten aus dem Web (rechtlich gesehen oft in der Grauzone zugegen) speisen Trainingsprozesse.

Modelle: Diffusionsmodelle (Bild/Video) und Sprach-/Stimmenmodelle lernen Muster und Stilmerkmale.

Generierung: Aus Textprompts oder Referenzmaterial entstehen "neue" Medieninhalte, die real wirken.

Optimierung: Feintuning, "model mixing" und Prompt-Techniken verbessern Plausibilität und Kohärenz.

Schon hier entscheidet die Qualität der Quellen maßgeblich über das Resultat: Schlechte Quellen skalieren Fehler - nicht Qualität.

Wo richten unverlässliche Quellen Schaden an?

Kontaminierte Trainingsdaten:

"Web-Crawls" (Gesammelte Inhalte von Websites) enthalten Fälschungen, Meme-Montagen, Clickbait, veraltete oder böswillig manipulierte Inhalte. Gelangen diese ungebremst in Trainingssets, beginnt ein "Kreislauf der Verzerrungen" in Zusammenarbeit mit KI-Modellen.

Scheinrecherche bei der Generierung:

Viele KI-Workflows "stützen" Ausgaben mit Websuche oder Retrieval. Greifen sie dabei auf SEO-Farmen, Mirror-Sites oder "Pseudo-Journalismus" zurück, werden falsche Narrative mit dem Irrglauben an technische Objektivität neu verpackt.

Halluzinative Attribution:

Sprachmodelle sind in der Lage Quellen zu "erfinden" (Halluzination).

Sobald diese Pseudo-Belege für visuelle oder stimmliche Deepfakes genutzt werden, erhöht das die scheinbare "Verifizierung" der Fälschung - ohne, dass eine echte Prüfung stattgefunden hat.

Feedback-Schleifen:

Einmal veröffentlicht, werden Deepfakes selbst zur "Quelle": Sie landen in Foren, werden zitiert, indexiert und schließlich wieder als Trainings- oder Prompt-Kontext benutzt. So wird Desinformation im Zeitalter des Digitalen Fußabdrucks verewigt.

Risiken

Politische Kommunikation & Wahlen: Gefälschte Politiker-Statements, manipulierte Mitschnitte, synthetische "Zeugen".

Unternehmen & Märkte: CEO-Fake-Calls, fabrikierte Produktleaks, Kursmanipulation durch gefälschte Pressevideos.

Rufschädigung & Erpressung: Intimfälschungen, falsche "Beweise", CEO-Fraud mit synthetischer Stimme.

Justiz & Verwaltung: Untergeschobene "Bodycam"-Clips, manipulierte Beweisfotos, gefälschte Amtskommunikation.

Plausibilität ≠ Wahrheit - die Psychologie dahinter:

Deepfakes verwenden kognitive Abkürzungen: Wenn Bild, Ton und vermeintliche Quelle zusammenpassen, steigt unsere Plausibilitätsheuristik. Die technische Güte verschiebt den Fokus von "Ist das echt?" hin zu "Es könnte echt sein". Unverlässliche Quellen liefern die fehlende letzte Stütze - ein Link, ein Logo, ein Wasserzeichen-Look-alike - mehr braucht es oft nicht.

Fortschritte & Grenzen bei der Erkennung:

Forensik: Analyse von Kompressionsartefakten, Inkonsistenzen in Schatten/Reflexion, Eye-Gaze, Mikroexpressionen.

Signaltechnik: Audio-Fingerprinting, Phonem-Timing, Spektrogramm-Anomalien.

Provenance-Standards: C2PA/Content Credentials betten Herkunftsdaten ein (Kamera → Edit → Veröffentlichung).

Grenzen: Modelle lernen schneller als offene Forensik-Tools sich anpassen. Zudem gehen Metadaten bei Re-Uploads verloren; Wasserzeichen lassen sich degradieren.

Governance: Was sollten Organisationen heute umsetzen?

Quelle vor Inhalt: Prozesse, die zuerst die Quelle und erst dann den Inhalt bewerten. Check: Domain-History, Impressum, Kontakt/Redaktion, Transparenz über Korrekturen.

Policy für KI-Nutzung:

Kein automatisiertes "Web-Stützen" ohne definierte Whitelists.

Retrieval nur aus kuratierter Wissensbasis; externe Quellen strikt gelabelt.

Verbot, generierte Inhalte als "belegt" auszugeben, wenn keine Primärquelle verifiziert ist.

Provenance by Design:

Eigene Medien mit Content Credentials signieren.

Workflows so bauen, dass Bearbeitungsschritte protokolliert werden (Audit-Trail).

Detektions-Stack: Kombination aus Bild/Video-Forensik, Voice-Spoofing-Erkennung, Modell-Wasserzeichentest und manueller Redaktion.

Incident-Playbook: Meldeketten, Takedown-Routinen (Plattformmeldungen, Host-Abuse), Krisen-Q&A, Gegenbeweise (Authenticity-Package mit Originaldateien, Hashes, Zeitstempeln).

Rechtsrahmen & Verträge: Nutzungsrechte an Trainingsdaten prüfen, NDAs/AGBs um KI-Klauseln ergänzen (Verbot synthetischer Darstellung von Führungskräften, klare Haftungsregeln).

Awareness & Training: Rollenspezifische Schulungen (PR, HR, Legal, IT). Praxisnahe Übungen mit echten/gefälschten Beispielen, sowie auch klaren Eskalationspfaden.

Checkliste - verdächtige Inhalte erkennen!

Wer veröffentlicht? (Erreichbare Redaktion? Historie? Impressum?)

Wann erstmals aufgetaucht? (Rückwärtssuche; erschien es zeitgleich auf mehreren unabhängigen, reputablen Seiten?)

Woher stammt das Original? (Primärquelle, Rohmaterial, EXIF/Metadaten, Hash-Abgleich)

Was passt nicht? (Licht/Schatten, Reflexe, Lippen-Ton-Sync, Hände/Ohren/Schmuck, Raumakustik) (äußerst wichtig bei der Erkennung eines Deepfakes!!!)

Welche Gegenbelege existieren? (Authentische Aufnahmen, offizielle Dementis mit Belegen, unabhängige Fact-Checks)

Wie groß ist der Anreiz? (Profit/Propaganda/Erpressung - motivierte Fälscher investieren mehr)

Schutzmaßnahmen für JEDE/-N

Kuratiertes Retrieval (RAG): Nur geprüfte, versionierte Wissensquellen; kein "freies" Web im Produktionsmodus.

Quellen-Scoring: Heuristiken + Reputationsdatenbanken (Domain-Alter, TLS-Historie, Verlinkungen, Fact-Check-Treffer).

Verifizierte Zitate: KI darf Zitate/Studien nur aus Quellen mit persistenten IDs (DOI, URN) und direkter Abrufbarkeit ausgeben.

Red-Teaming: Regelmäßige Angriffe auf eigene Workflows (Prompt-Injection, gefälschte Snippets, poisoned PDFs).

Content-Watermarking & Hashing: Eigene Veröffentlichungen markieren, um später echte von falschen Kopien abzugrenzen.

Human-in-the-Loop: Kritische Veröffentlichungen benötigen 4-Augen-Prinzip mit dokumentierter Quellenprüfung.

Fazit:

Deepfakes sind kein bloßes Technikproblem - sie sind ein Quellenproblem. Solange Generations- und Recherche-Pipelines unkritisch auf das offene Web zugreifen, wird "plausibel" zu oft mit "wahr" verwechselt. Die Antwort liegt in harter Quellenkurierung, nachvollziehbarer Provenance und gelebter Prüfkultur.

Link zu der Homepage des Bildungsinstitut Wirtschaft